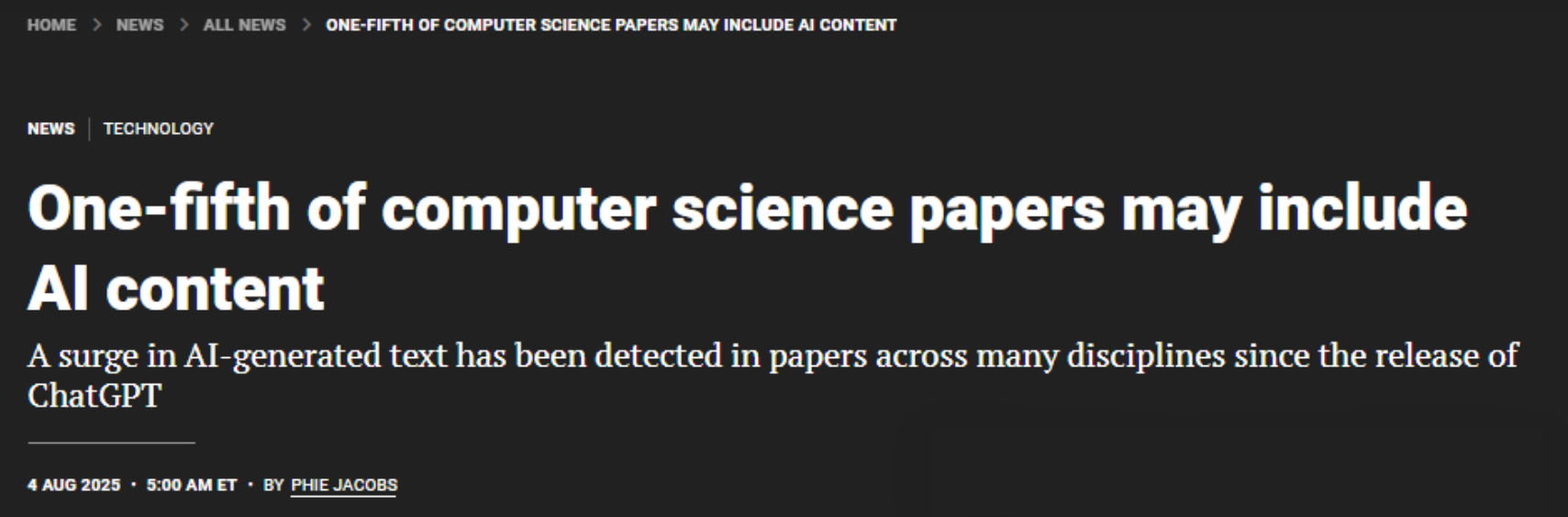

如今翻阅最新的计算机科学论文,你有近四分之一的概率会发现,摘要并非完全出自人类之手。2025 年 8 月 4 日,Nature Human Behaviour 期刊刊登的斯坦福大学研究,揭示了人工智能在学术写作中惊人的融入程度。研究团队分析 2020 至 2024 年间 112 万余篇科学论文及预印本后发现,自 2022 年 11 月 ChatGPT 出现,学术论文里 AI 修改的痕迹便激增。

AI渗透学术写作,计算机领域高达四分之一

斯坦福大学计算生物学家 James Zou 带领团队,用了个巧妙的检测办法:分析论文摘要和引言里 AI 生成文本更常见的特征词,以此追踪 AI 在学术写作中的踪迹。

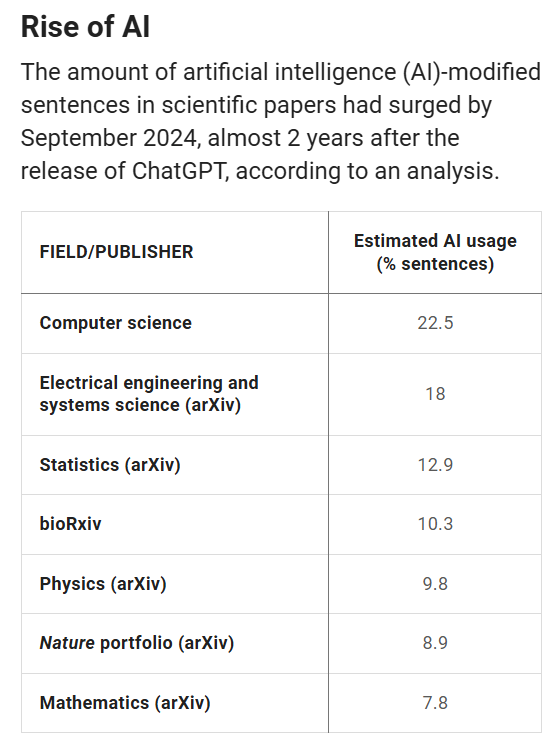

结果显示,不同学科对 AI 的接受度差别很大。到 2024 年 9 月,计算机科学论文摘要中,有 22.5% 能看出 AI 修改的痕迹;电气工程和系统科学领域紧随其后,在 arXiv 平台上这一比例是 18%。

与之相比,数学领域论文的 AI 痕迹占比仅 7.7%。这种差异很明显:学科离 AI 技术越近,论文被 AI “染指” 的比例就越高。

“写一篇论文往往要花数月甚至数年,可 AI 使用趋势冒出来这么快,说明大家一开始就很快用上了它。”James Zou 这样评价这一现象。

AI 痕迹难辨,检测遇挑战

随着 AI 在学术写作中越来越普及,一场关于 AI 痕迹检测的 “猫鼠游戏” 悄悄展开。

一开始,AI 生成的文本有明显 “标记”。研究人员发现,不少论文里出现了 “再生反应”“我的知识截止” 这类奇怪短语。图卢兹大学计算机科学家 Guillaume Cabanac 等学者,甚至开始整理含这些 “铁证” 的论文清单。

2024 年 3 月,路易斯维尔大学讲师 Alex Glynn 建了个 Academ AI 数据库,专门记录科学论文中疑似用了 AI 的案例。“表面看挺有意思,但其影响实在让人不安。”Glynn 指出,AI 会 “编造” 虚假信息的特点,给期刊质量控制出了个大难题。

但技术在进步,作者们也越来越会掩盖 AI 痕迹。2023 年一项研究显示,研究人员读 ChatGPT 写的医学摘要时,有三分之一认不出是机器写的。现有的 AI 检测工具不仅可靠性存疑,还对非母语作者有偏见。

新追踪法:从语言细节抓 AI 痕迹

面对越来越隐蔽的 AI 写作,科学家们想出了更细致的追踪办法。蒂宾根大学数据科学家 Dmitry Kobak 团队换了个思路,通过分析 “多余单词” 的出现频率异常来识别 AI 痕迹。

他们研究 2010 到 2024 年的 1500 万篇生物医学论文后发现,ChatGPT 发布后,“深入研究” 这类词出现的频率明显上升。研究显示,2024 年发表的生物医学摘要中,约七分之一可能有 AI 帮忙。

James Zou 团队则建了套更系统的识别模型。他们以 AI 文本里更常出现的词(比如科学写作中不常见的 “关键”“复杂”“展示” 等)为基础,训练出专门的统计模型。把这模型用到百万级论文库时,清晰捕捉到了 ChatGPT 出现后 AI 修改内容的激增曲线。

“不管是好是坏,大型语言模型确实成了科学过程本身的一部分。”Zou 的话,道出了 AI 已深度融入科研生态的现状。

AI 是助手还是隐患?

AI 在学术写作中普及,学界也开始担心其潜在影响。Dmitry Kobak 警告,要是作者依赖 AI 写文献综述,可能导致论文的相关工作部分越来越像,最终形成 “恶性循环”—— 新 AI 模型训练时,吸收的竟是前代 AI 生成的内容。

更让人担心的是质量控制问题。要是经过多轮同行评审的论文,最后被发现是 AI 写的,学术出版系统的可信度就会受冲击。Glynn 直言:“这影响太让人不安了。”

面对这些挑战,James Zou 团队打算做个更大胆的尝试 —— 办一场全由 AI 当作者和审稿人的学术会议。“我猜会有不少有趣的发现,也会有很多有意思的错误。”Zou 对这场前所未有的实验充满期待。

当 22.5% 的计算机论文已留下 AI 印记,这场学术革命才刚起步。AI 写作工具正从 “辅助者” 变成 “参与者”,改变着知识生产的本质。

随着技术门槛降低,学术圈的核心挑战已不是用不用 AI,而是怎么建立适配的学术伦理和质量控制体系。在效率与严谨的平衡中,整个学界都在找新的支点 —— 毕竟当机器开始书写知识,人类更得清楚定义什么是真正的创造。

19123189289

19123189289  dissertation@delpvip.com

dissertation@delpvip.com 渝公网安备50019002504948号

渝公网安备50019002504948号